Content Marketing-Spezialisten wetteifern stets darum, perfekte SEO-optimierte Inhalte zu erstellen. Doch seit wann und warum ist das so? Im folgenden Artikel möchten wir einen Einblick in die Entstehungsgeschichte der Suchmaschinenoptimierung geben: Wie hat sie sich entwickelt und wo geht die Reise hin.

Seit wann gibt es SEO?

Das Konzept der Suchmaschinenoptimierung gab es bereits vor der Gründung von Google. Einer Erzählung zufolge war die Band „Jefferson Starship“ einer der Treiber für Suchmaschinenmarketing. Mitte der 90er Jahre erhielt der Promoter Bob Heyman einen verärgerten Anruf der Band, die auf Tour ihre eigene Webseite nicht mehr finden konnte. Mehrere Fanseiten hatten so leidenschaftliche Artikel verfasst, dass sie die offizielle Bandseite in den Suchergebnissen übertrafen. In der Folge erhöhten Heyman und sein Partner Leland Harden die Verweise auf die offizielle Bandseite und brachten sie so wieder zurück an die Spitze der Suchergebnisse.

Wer hat den Begriff SEO erfunden?

Laut dieser Anekdote haben Heyman und Harden den Begriff SEO erfunden. Doch Experten fragen sich, wie viel von dieser Geschichte wirklich wahr ist. Denn zu diesem Zeitpunkt benötigte man zur Performancesteigerung lediglich eine funktionierende Webseite, einige eingehende und ausgehende Links sowie Verweise auf die Schlüsselbegriffe. Mitte bis Ende der neunziger Jahre begannen die ersten IT-Pioniere, diese Methoden anzuwenden und erzielten durchaus beachtliche Ergebnisse.

Als erstes Unternehmen verwendete im Jahr 1997 die Webstep Marketing Agency den Begriff „Suchmaschinenoptimierung“ in ihren Marketingmaterialien. Um 1998 begann Danny Sullivan, der Gründer von Search Engine Watch, den Begriff zu etablieren und Kundeninhalte so zu optimieren, dass diese in den Suchmaschinenergebnissen gut platziert werden. Im Jahr 2003 tauchte der Begriff „Suchmaschinenoptimierung“ zum ersten Mal auf Wikipedia auf und zementierte seinen Status in der Internetbranche. In der Folge entstand eine ganze Branche von Beratern und Analysten, die Unternehmen dabei unterstützten, in den Suchmaschinenergebnissen ganz nach oben zu kommen.

Der gescheiterte Versuch, den Begriff „SEO“ urheberrechtlich zu schützen

Obwohl sich SEO gerade erst etablierte, verwendeten viele Marketingexperten Black Hat-Taktiken oder Word Stuffing, um bessere Ergebnisse zu erzielen. Im Jahr 2007 versuchte Jason Gambert den Begriff „SEO“ markenrechtlich zu schützen; angeblich, um die Integrität der Suchmaschinenoptimierung schützen und das Internet vor missbräuchlicher Nutzung zu bewahren. Dieses Ansinnen wurde jedoch 2008 vom US-Patentamt abgelehnt.

SEO und der Aufstieg von Google

Zwar gab es SEO schon vor Google, doch erst mit dem Aufstieg von Google bekam auch SEO die notwendige Aufmerksamkeit. Denn SEO bezieht zwar alle Suchmaschinen mit ein, doch 93% der Suchmaschinennutzung entfällt auf das von Larry Page and Sergey Brin gegründete Unternehmen. Eine Dominanz, die auch in Zukunft nicht so schnell verschwinden wird. Einer der Hauptgründe, warum Google sich gegen Yahoo, AltaVista, Dog Pile, Infoseek, Ask Jeeves und andere durchsetzen konnte, ist die Bereitstellung besserer Suchergebnisse, da Google stets in die Optimierung seiner Prozesse investierte. So werden seit 2021 bei der Ermittlung der SEO-Rankings mehr als 200 Faktoren ausgewertet, die im Laufe der Zeit immer weiter zugenommen haben.

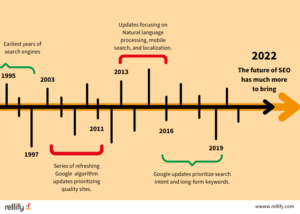

Wie hat sich SEO entwickelt?

Da Google seit einigen Jahren die dominierende Kraft in der SEO-Branche ist, drehen sich viele wichtige Daten um das letzte Google Core Update. Ein Blick durch die Google-Brille kann also äußerst hilfreich sein, um zu verstehen, wie sich die herkömmliche Suche im Laufe der Jahre verändert hat und welche Kriterien am wichtigsten sind.

Google hat immer neue Algorithmen eingeführt und bietet verschiedene Funktionen, die die Gesamtqualität der Suchergebnisse verbessern. Matt Cutts, von 2001 bis 2016 Leiter der Abteilung Webspam und Suchingenieur bei Google, hat viele dieser Updates entworfen. Jedes Algorithmus-Update hat für Content Marketing-Spezialisten entweder eine zermürbende oder eine begeisterte Wirkung, da die Indizierung von Domains und die Bestimmung, was tatsächlich „relevanter Inhalt“ ist, neu geordnet werden. Daher ist ein Blick auf die Geschichte hilfreich, um neue Branchentrends vorherzusagen.

Wie haben sich die Google Algorithmen verändert?

Die Geschichte der Suchmaschinenoptimierung (SEO) ist voll von Änderungen der Google-Algorithmen. Sie alle verfolgen das Ziel, den Nutzern relevantere Inhalte zu bieten. Diese Aktualisierungen haben in der Regel eine von drei Wirkungen: Sie filtern Spam und Black Hat-Taktiken heraus, bevorzugen neu, relevante, lokale Inhalte oder liefern relevante Ergebnisse für semantische Suchen. Wenn Sie diese Entwicklung verstehen, können Sie besser nachvollziehen, wie die herkömmliche Suche immer weiter verfeinert wurde. Sie verstehen auch, wie Algorithmen auf früheren aufbauen. Doch Google verfeinert und aktualisiert seine Updates immer weiter: Auch wenn ein Algorithmus mehr als ein Jahrzehnt alt ist, wirkt er sich noch heute auf die Suchergebnisse aus. Version 4 eines Algorithmus wird ganz anders aussehen als Version 1. Die folgenden Algorithmen haben dabei die Geschichte der Suchmaschinenoptimierung maßgeblich geprägt:

| 1996 | Page Rank | Dieses frühe Projekt, das von Sergey Brin und Larry Page entwickelt wurde, ebnete den Weg: Es gewichtete Faktoren wie Domain-Autorität sowie interne und externe Links. Dieser Algorithmus schuf zwar eine solide Grundlage für die automatische Indizierung des Internets, war aber dennoch anfällig für Black Hat-Taktiken. |

| 2003 | Florida | Dies war das erste große Update des Google-Algorithmus, mit dem Websites mit einer großen Anzahl minderwertiger Links herausgefiltert werden sollten. Es wurde im November veröffentlicht und hatte für viele Websites einen massiven Umbruch zur Folge, und das genau auf dem Höhepunkt der Weihnachtseinkaufssaison. Leider wurden viele qualitativ hochwertige Websites falsch eingestuft, was kleinen Unternehmen gründlich schadete. Dennoch hat die Einführung der Linkanalyse dazu beigetragen, die Entwicklung der Suchmaschinenoptimierung zu beeinflussen. |

| 2004 | Trust Rank | Der TrustRank-Algorithmus ging einen Schritt über die Gründung von Florida hinaus und diente dazu, SPAM und Black Hat-Techniken aus anderen Suchmaschinenergebnissen herauszufiltern. Dieser Algorithmus hilft dabei, die Vertrauenswürdigkeit von Domains zu berücksichtigen, damit die Nutzer qualitativ hochwertige Wirkungen erhalten. |

| 2010 | Google Koffein |

Dieser Algorithmus gab den Google-Suchergebnissen einen ordentlichen Energieschub, da die Kapazität zur Indizierung von Artikeln erhöht wurde und die Suchergebnisse frischere Inhalte bevorzugen konnten. |

| 2011 | Google Panda |

Google Panda wurde entwickelt, um Nutzer auf qualitativ hochwertigere Websites, wie z.B. Nachrichtenorganisationen, zu leiten und die Auswirkungen von Content-Farmen mit dünn geschriebenen, schlecht zitierten Artikeln zu minimieren. |

| 2011 | Google Freshness | Einige Websites können, wie ein gutes Rezept, zeitlos sein, aber die überwiegende Mehrheit benötigt recht häufig Aktualisierungen. Der Google Freshness-Algorithmus tut genau das, was man erwarten würde: Er priorisiert frische, tatsächliche Inhalte und war eine Verbesserung des zuvor veröffentlichten Caffeine. |

| 2012 | Google Penguin |

Wie Panda ging auch Google Penguin gegen Spam-Websites vor und versuchte, Inhalte auszusortieren, die sich heimlicher Techniken bedienten, um ihre Rankings zu verbessern. Spam-Websites, die Seiten mit vielen externen Links einrichten, um ihre Domain-Autorität und ihre Position in den Suchergebnissen zu verbessern. |

| 2013 | Google Hummingbird | Dieser robuste Algorithmus bot einen massiven Übergang zur Bevorzugung der natürlichen Sprache bei Suchanfragen. Anstelle von Keyword-Packing und unnatürlichen Versuchen, alle notwendigen Wörter in einen Artikel einzubauen, gab Hummingbird der natürlichen Sprache den Vorrang. Diese massive Veränderung stellte einen neuen Weg dar und legte den Grundstein für zukünftige Verbesserungen der künstlichen Intelligenz und der Verarbeitung natürlicher Sprache. |

| 2015 | Google Mobilegeddon | Dieses Update gab Websites, die für Mobilgeräte optimiert sind, einen großen Schub. Anstelle von klobigen Oberflächen, die auf dem Desktop vielleicht gut aussehen, hat die verbesserte Optimierung für Mobilgeräte ein viel besseres Benutzererlebnis geschaffen. Mobilegeddon und die Priorisierung mobiler Websites trugen dazu bei, diesen Wandel zu beschleunigen. Der Anteil der mobilen Suche ist von etwa 20% im Jahr 2013 auf über 60% im Jahr 2021 gestiegen. |

| 2015 | Google Rankbrain | Dieser gründliche Algorithmus, der in gewisser Weise eine Erweiterung von Google Hummingbird ist, sorgte für mehr Klarheit bei unstrukturierten Daten. Seine Hauptaufgabe besteht also darin, zu verstehen, was von Ihnen gewünscht wird, auch wenn Sie keine „Anführungszeichen“ um Ihre Anfrage herum verwenden. Wenn Sie zum Beispiel John Smith eingeben, sucht es nicht nach allen Johns und allen Smiths und sieht, wo sie sich überschneiden, sondern es sucht nach den eindeutigen „John Smiths“. Das ist auch ein gründlicher Baustein für die Bedeutung der natürlichen Sprachverarbeitung und ihre Auswirkungen auf die Suche sowie die lokale Suche. |

| 2016 | Google Possum |

Fragt Google Sie jemals nach Ihrem Standort, wenn Sie suchen? Google Possum ebnete den Weg für lokale Wirkungen. Dieses Algorithmus-Update brachte gründliche Änderungen für die lokale Suchmaschinenoptimierung mit sich und bot lokalen Unternehmen eine Möglichkeit, mit ihrem Publikum in Kontakt zu treten. Wenn Sie also nach „bestes Brathähnchen“ suchen, werden Sie wahrscheinlich nicht die Wirkung einer universellen Suche nach allen Hähnchenrestaurants der Welt sehen. Stattdessen sehen Sie maßgeschneiderte Pizzerien aus Ihrer Region. |

| 2017 | Google Fred |

Wenn Ihre Website auf Black-Hat-SEO-Taktiken gesetzt hatte, spürten Sie wahrscheinlich einen Einbruch, nachdem Google Fred eingeführt hatte. Dieser Algorithmus zielte darauf ab, schlechte Websites mit einem Übermaß an Zeitungsanzeigen und weniger hochwertigen Inhalten zu bestrafen. |

| 2018 | Google Medic |

Jeder, der schon einmal Dr. Google um Antworten auf verschiedene medizinische Fragen gebeten hat, weiß, wie wichtig es ist, vertrauenswürdige medizinische Quellen in Ihren Suchergebnissen zu haben. Dieser Algorithmus hat dazu beigetragen, dass Websites mit medizinischer Autorität, wie die Cleveland Clinic oder die Mayo Clinic, gegenüber anderen ohne medizinische Autorität bevorzugt werden. |

| 2019 | Google BERT |

Dieser leistungsstarke Algorithmus verbesserte die Grundlage von Hummingbird und priorisierte Suchintentionen und Keywords in Langform. Durch BERT wurde die Suchqualität verbessert und der Relevanz Vorrang eingeräumt. |

Auswirkungen auf die Zukunft

Suchmaschinenmarketing ist heutzutage also ein hochspezialisierter Prozess, der ein Team von Experten sowie komplexe Datensätze und Modelle erfordert. Dies scheint Lichtjahre entfernt vom Keyword-Stuffing und Link-Sharing früherer Jahrzehnte. Doch SEO ist im Kern immer gleich geblieben. Suchmaschinen wollen den Lesern die bestmöglichen Antworten auf ihre Suchanfragen geben: Und Unternehmen möchten die Experten sein, die die gewünschte Ergebnisse liefern. Die Qualität der Inhalte ist also entscheidend. Dank der Weiterentwicklung von Machine Learning und Künstlicher Intelligenz bekommen wir immer spezialisiertere Suchergebnisse – welche die natürliche Sprachverarbeitung nutzen, um bessere und genauere Suchergebnisse zu liefern.

Wie bleiben meine Inhalte auch in Zukunft SEO-optimiert?

Google verfeinert seine Algorithmen ständig und bietet in der Regel zweimal im Jahr größere Algorithmus-Updates an. Einige der Richtlinien sind ziemlich eindeutig, z. B. die Priorisierung von Artikeln nach E-A-T (Expertise – Authority – Trustworthiness; auf deutsch Branchenkompetenz – Ansehen – Vertrauenswürdigkeit). Doch selbst wenn Sie stets alle Richtlinien beachten, kann es sein, dass Sie gelegentlich unerwartete Schwankungen auf Ihrer Webseite feststellen.

Stellen Sie fest, dass Ihre Inhalte ohne logischen Grund an Traffic verlieren, geraten Sie nicht in Panik! Dies liegt wahrscheinlich an einem neuen Google Core Update und Ihre Seite benötigt entsprechende Anpassungen. Doch wenn Ihre Inhalte gut geschrieben sind, Ihre Website technisch einwandfrei ist und Sie die Fragen beantworten, die sich Ihre Zielgruppe auch stellt, sollte sich Ihr organischer Traffic mit dem nächsten Update normalisieren oder gar verbessern. Behalten Sie daher stets die langfristigen Auswirkungen im Blick: Jährliche Performance-Messungen sind oft aussagekräftiger als monatliche.

Diese Schwankungen sind ein Grund, warum Unternehmen wie rellify so wichtig sind. Dank maschinellem Lernen nutzen wir branchenspezifische Daten und werten nur die Daten aus, die für Ihr Unternehmen und Ihre Branche auch wirklich relevant sind. So kombinieren wir künstliche und menschliche Intelligenz, um genau die Inhalte zu entwickeln, die Ihre Zielgruppe tatsächlich interessieren. So können Sie sich auch unabhängig vom nächsten Google-Update sicher sein, dass Ihre Content Marketing-Bemühungen die gewünschte Wirkung zeigen.

Sprechen Sie uns an für mehr Informationen.